Integrace generativní umělé inteligence do podnikových pracovních postupů není záležitostí budoucnosti; děje se právě teď, tempem, které často převyšuje možnosti zabezpečení a správy. Na každé zdokumentované a schválené použití nástroje umělé inteligence, který zvyšuje produktivitu, existuje nespočet případů „stínového“ použití, které vystavuje organizace významným hrozbám. Výzva pro bezpečnostní analytiky, CISO a IT manažery je jasná: jak umožnit inovace, které umělá inteligence slibuje, aniž bychom s sebou přinášeli nepřijatelná rizika? Odpověď spočívá v disciplinovaném a proaktivním přístupu k řízení rizik umělé inteligence. Nejde o blokování pokroku; jde o budování zábran, které vaší organizaci umožní bezpečně zrychlit.

Rostoucí potřeba správy umělé inteligence

Než bude možné implementovat jakoukoli účinnou strategii řízení rizik, musí být stanoveny základy pro správu a řízení umělé inteligence (AI). Rychlé a decentralizované zavádění nástrojů umělé inteligence znamená, že bez formální struktury správy a řízení organizace pracují v nevědomosti. Zaměstnanci, kteří dychtí po zlepšení své efektivity, si nezávisle osvojí různé platformy a pluginy umělé inteligence, často bez ohledu na bezpečnostní důsledky. To vytváří složitou síť neschváleného používání SaaS, kde mohou být citlivá firemní data, od osobních údajů a finančních záznamů až po duševní vlastnictví, neúmyslně odcizena do modelů LLM (Large Language Models) třetích stran.

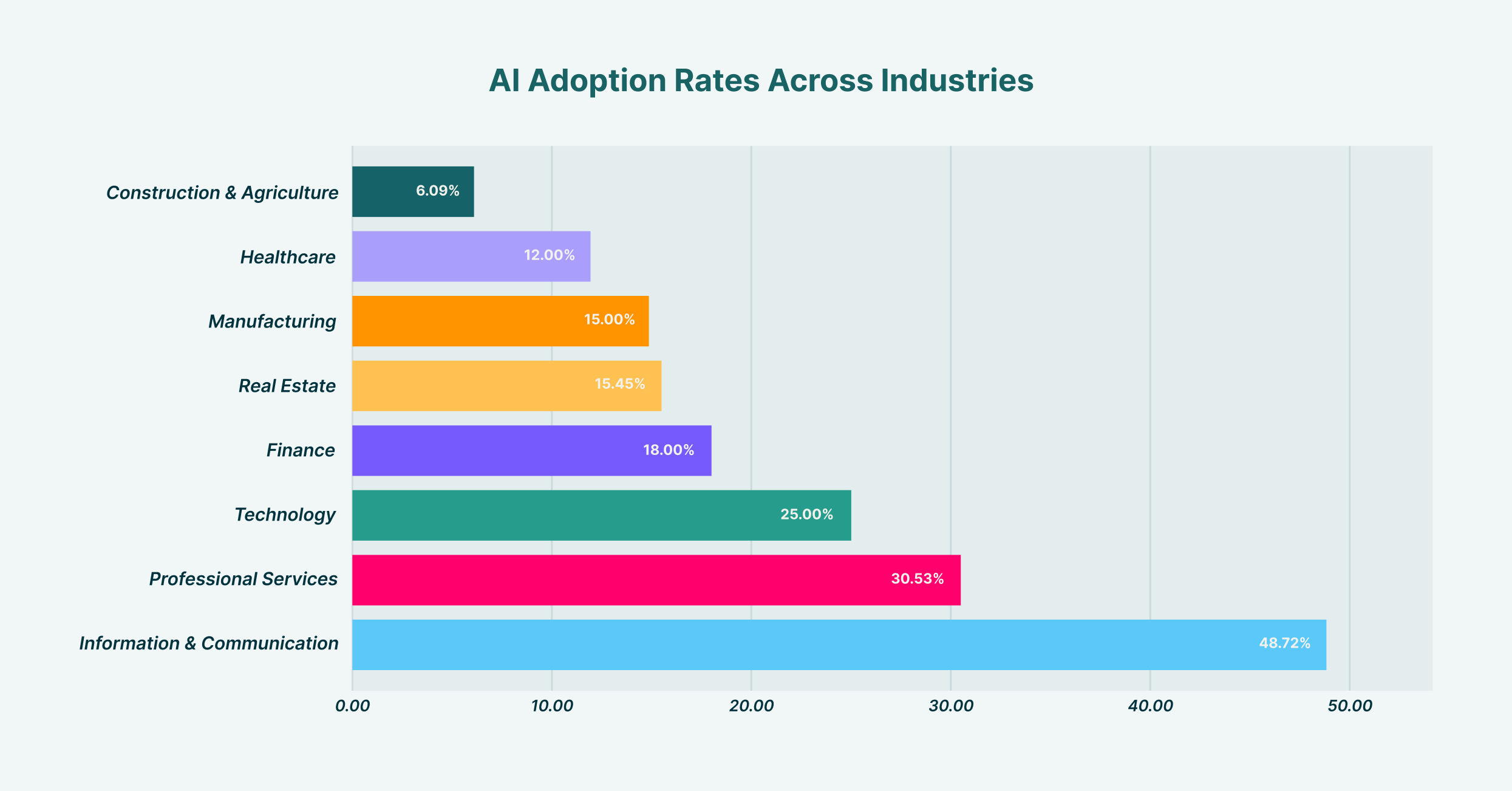

Zavádění umělé inteligence se v jednotlivých odvětvích výrazně liší, přičemž odvětví informačních a komunikačních technologií vede s 48.7 % a stavebnictví a zemědělství je na nejnižším místě s 6.1 %.

Zavedení robustní správy a řízení AI zahrnuje vytvoření mezioborového týmu, který obvykle zahrnuje zástupce IT, bezpečnostního, právního a obchodního oddělení. Tento výbor má za úkol definovat postoj organizace k AI. Jaká je naše chuť k riziku? Které případy užití jsou podporovány a které jsou zakázány? Kdo je odpovědný, když dojde k incidentu souvisejícímu s AI? Zodpovězení těchto otázek poskytuje jasnost potřebnou pro vytvoření politik a kontrol. Bez tohoto strategického směřování shora dolů se jakýkoli pokus o řízení rizik stává spíše řadou nesouvislých, reaktivních opatření než soudržnou obranou. Tento rámec správy a řízení se stává plánem pro veškeré následné bezpečnostní úsilí a zajišťuje soulad technologií, politik a chování uživatelů.

Vytvoření rámce pro řízení rizik v oblasti umělé inteligence

Po zavedení struktury řízení je dalším krokem vytvoření formálního rámce pro řízení rizik v oblasti umělé inteligence. Tento rámec operacionalizuje vaše principy řízení a proměňuje strategii na vysoké úrovni v konkrétní, opakovatelné procesy. Poskytuje strukturovanou metodu pro identifikaci, hodnocení, zmírňování a monitorování rizik souvisejících s umělou inteligencí v celé organizaci. Organizace mohou namísto znovuobjevování kola přizpůsobit zavedené modely, jako je například rámec pro řízení rizik v oblasti umělé inteligence NIST, tak, aby odpovídaly jejich specifickému provoznímu kontextu a prostředí hrozeb.

Vývoj efektivního rámce pro řízení rizik v oblasti umělé inteligence by měl být metodickým procesem. Začíná vytvořením komplexního inventáře všech používaných systémů umělé inteligence, a to jak schválených, tak neschválených. Tato počáteční fáze objevování je kritická; nemůžete chránit to, co nevidíte. Po objevení by měl rámec nastínit postupy pro posouzení rizik, přiřazování skóre na základě faktorů, jako je typ zpracovávaných dat, možnosti modelu a jeho integrace s dalšími kritickými systémy. Na základě tohoto posouzení jsou poté navrženy strategie zmírňování rizik, od technických kontrol a školení uživatelů až po úplný zákaz vysoce rizikových aplikací. Rámec musí nakonec zahrnovat kadenci pro průběžné monitorování a kontrolu, protože jak ekosystém umělé inteligence, tak jeho využívání vaší organizací se budou neustále vyvíjet. Existují různé rámce pro řízení rizik v oblasti umělé inteligence, ale nejúspěšnější jsou ty, které nejsou statickými dokumenty, ale živoucími, dýchajícími součástmi bezpečnostního programu organizace.

Kategorizace rizik umělé inteligence: Od úniku dat k otravě modelů

Klíčovou součástí AI a řízení rizik je pochopení specifických typů hrozeb, kterým čelíte. Rizika nejsou monolitická; pokrývají celé spektrum od narušení ochrany osobních údajů až po sofistikované útoky proti samotným modelům AI. Jednou z nejbezprostřednějších a nejběžnějších hrozeb je únik dat. Představte si marketingového analytika, který vkládá seznam vysoce hodnotných leadů včetně kontaktních informací do veřejného nástroje GenAI, aby mohl vytvářet personalizované e-maily. V tu chvíli jsou citlivá zákaznická data odcizena a nyní jsou součástí školicích dat LLM, mimo kontrolu vaší organizace a potenciálně v rozporu s předpisy o ochraně osobních údajů, jako je GDPR nebo CCPA.

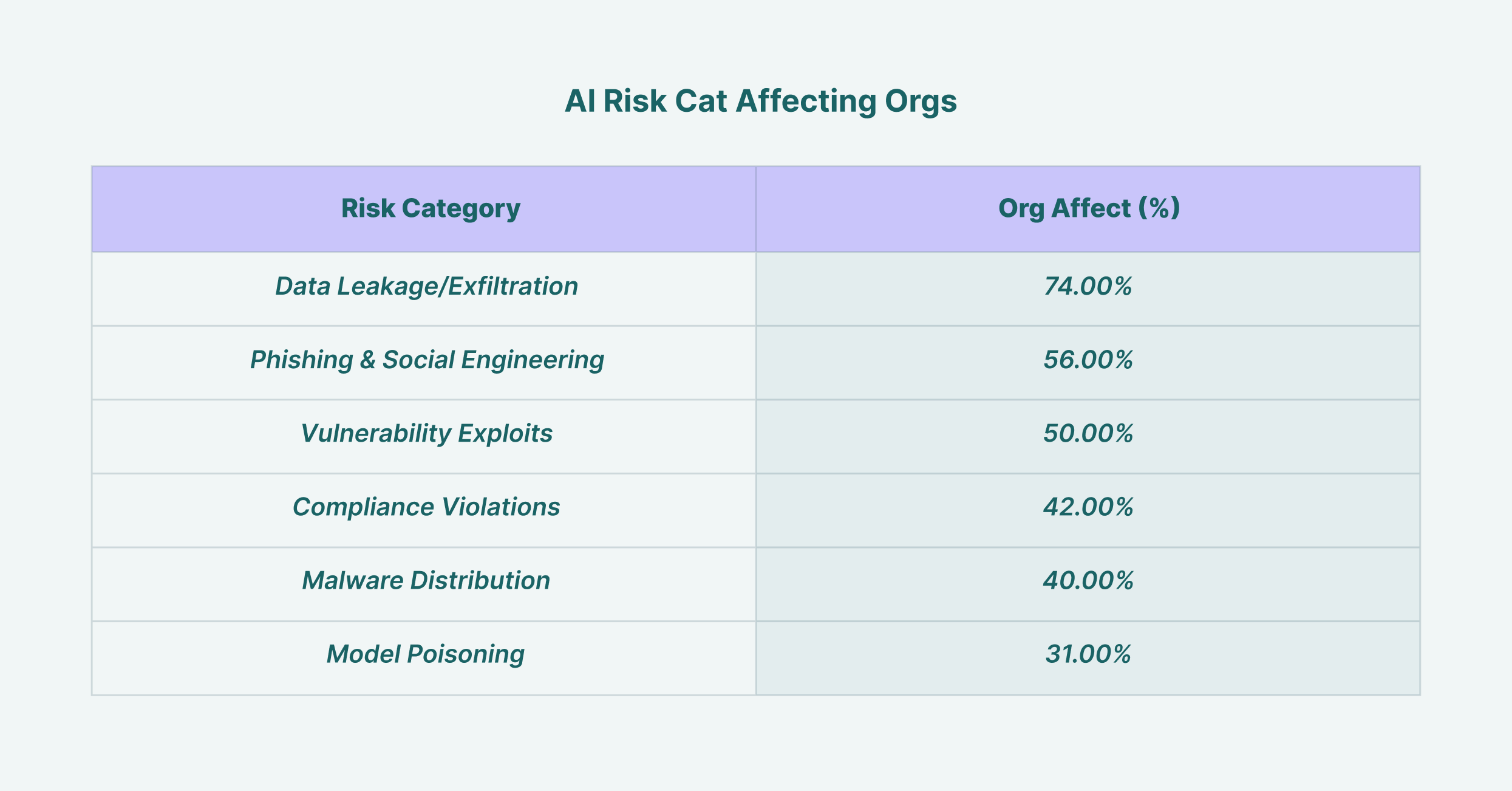

Únik dat postihuje 74 % organizací, což z něj činí nejrozšířenější bezpečnostní riziko v oblasti umělé inteligence, následované phishingovými útoky s 56 %.

Kromě úniku dat se bezpečnostní lídři musí potýkat i s pokročilejšími hrozbami. K otravě modelu dochází, když útočník úmyslně zadá modelu škodlivá data během jeho trénovací fáze, což způsobí, že model produkuje zkreslené, nesprávné nebo škodlivé výstupy. Útoky s cílem vyhnout se kontrole zahrnují vytváření vstupů, které jsou speciálně navrženy tak, aby obešly bezpečnostní filtry systému umělé inteligence. Pro CISO znamená efektivní využití umělé inteligence v řízení rizik také využití bezpečnostních nástrojů založených na umělé inteligenci k detekci právě těchto hrozeb. Pokročilé systémy pro detekci hrozeb dokáží analyzovat chování uživatelů a toky dat a identifikovat anomální aktivity svědčící o bezpečnostním incidentu souvisejícím s umělou inteligencí, čímž se technologie mění ze zdroje rizika na součást řešení.

Klíčová role bezpečnostní politiky umělé inteligence

Abyste mohli svůj rámec převést do jasných směrnic pro své zaměstnance, je specializovaná bezpečnostní politika pro umělou inteligenci nepodstatná. Tento dokument slouží jako autoritativní zdroj informací o přijatelném používání umělé inteligence v organizaci. Měl by být jasný, stručný a snadno přístupný všem zaměstnancům, aby nenechával prostor pro nejednoznačnost. Dobře propracovaná bezpečnostní politika pro umělou inteligenci jde nad rámec jednoduchých „co dělat a nedělat“ a poskytuje kontext, vysvětluje… proč Jsou zavedena určitá omezení, která podporují kulturu bezpečnostního povědomí, spíše než pouhé dodržování předpisů.

Tato politika musí explicitně definovat několik klíčových oblastí. Zaprvé by měla vyjmenovat všechny schválené a povolené nástroje umělé inteligence spolu s postupem pro vyžádání si hodnocení nového nástroje. Tím se zabrání šíření stínové umělé inteligence. Zadruhé musí stanovit jasné pokyny pro nakládání s daty, které specifikují, jaké typy firemních informací (např. veřejné, interní, důvěrné, omezené) lze použít s jakou kategorií nástrojů umělé inteligence. Například použití veřejného nástroje GenAI pro shrnutí veřejně dostupných zpravodajských článků může být přijatelné, ale jeho použití k analýze důvěrných finančních prognóz by bylo přísně zakázáno. Politika by měla také nastínit odpovědnosti uživatelů, důsledky nedodržování předpisů a protokol reakce na incidenty v případě podezření na narušení bezpečnosti související s umělou inteligencí, aby se zajistilo, že každý rozumí své roli v ochraně organizace.

Hodnocení modelů a pluginů: Zaměření na řízení rizik třetích stran v oblasti umělé inteligence

Moderní ekosystém umělé inteligence je postaven na komplexním dodavatelském řetězci modelů, platforem a pluginů vyvinutých třetími stranami. Tato skutečnost činí z řízení rizik umělé inteligence třetích stran klíčový pilíř vaší celkové bezpečnostní strategie. Pokaždé, když zaměstnanec povolí nový plugin pro svého asistenta umělé inteligence nebo váš vývojový tým integruje API třetí strany, rozšiřuje tím oblast útoku vaší organizace. Každá z těchto externích komponent nese svou vlastní sadu potenciálních zranitelností, zásad ochrany osobních údajů a bezpečnostních opatření, která nyní vaše organizace dědí.

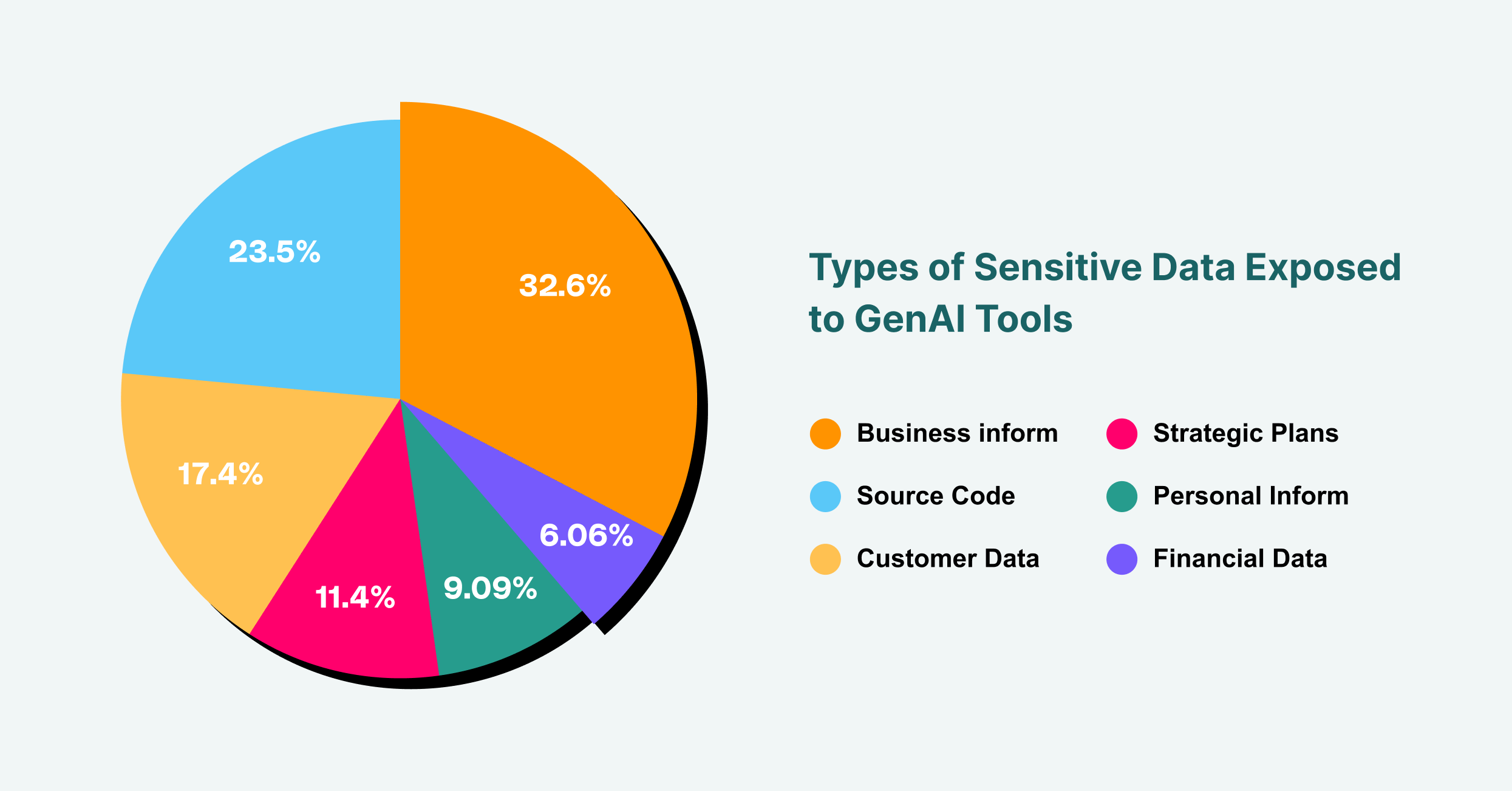

Obchodní informace tvoří 43 % citlivých dat vystavených GenAI, následuje zdrojový kód s 31 % a zákaznická data s 23 %.

Proto je nezbytný důkladný proces hodnocení. Než je jakýkoli nástroj nebo komponenta umělé inteligence od třetí strany schválena k použití, musí být podrobena důkladné kontrole zabezpečení a ochrany osobních údajů. To zahrnuje kontrolu bezpečnostních certifikací dodavatele, postupů pro nakládání s daty a schopností reakce na incidenty. Jaká data nástroj shromažďuje? Kde jsou uložena a kdo k nim má přístup? Má dodavatel historii narušení bezpečnosti? U pluginů umělé inteligence, které jsou rostoucím vektorem útoků z prohlížeče, by měl být proces prověřování ještě přísnější. Mezi otázky, které je třeba si položit, patří: Jaká oprávnění plugin vyžaduje? Kdo je vývojářem? Byl jeho kód auditován? Tím, že budete s každou službou umělé inteligence třetí strany zacházet se stejnou úrovní kontroly jako s jakýmkoli jiným kritickým dodavatelem, můžete zmírnit riziko útoku na dodavatelský řetězec, který by ohrozil vaši organizaci.

Implementace nástrojů pro řízení rizik s využitím umělé inteligence

Zásady a procesy jsou základní, ale bez technického vymáhání nestačí. A právě zde se nástroje pro řízení rizik v oblasti umělé inteligence stávají nezbytnými. Tato řešení poskytují přehled a kontrolu nezbytnou k zajištění toho, aby vaše bezpečnostní zásady v oblasti umělé inteligence byly dodržovány v praxi, nejen v teorii. Vzhledem k tomu, že primárním rozhraním pro většinu uživatelů interagujících s GenAI je webový prohlížeč, jsou nástroje, které mohou fungovat na této úrovni, jedinečně postaveny k zajištění efektivního dohledu.

Rozšíření nebo platformy podnikových prohlížečů, jako je LayerX, nabízejí výkonný mechanismus pro řízení rizik spojených s umělou inteligencí. Dokážou odhalit a zmapovat veškeré využití GenAI v celé organizaci a poskytnout tak přehled o tom, kteří uživatelé přistupují ke kterým platformám v reálném čase. Tato viditelnost je prvním krokem k vypnutí stínové umělé inteligence. Odtud mohou tyto nástroje vynucovat podrobná, na rizicích založená ochranná opatření. Můžete například nakonfigurovat zásady, které uživatelům zabrání vkládat text označený jako „důvěrný“ do veřejného chatbota s umělou inteligencí nebo které uživatele varují před nahráním citlivého dokumentu. Tato vrstva ochrany monitoruje a řídí tok dat mezi prohlížečem uživatele a webem a efektivně funguje jako řešení prevence ztráty dat (DLP) speciálně přizpůsobené pro věk umělé inteligence. Správné nástroje pro řízení rizik spojených s umělou inteligencí překlenují propast mezi zásadami a realitou a poskytují technické prostředky k vynucení vašich rozhodnutí v oblasti správy a řízení.

Řešení incidentů a reakce na ně ve věku umělé inteligence

I s nejlepšími preventivními opatřeními může k incidentům dojít. Způsob, jakým vaše organizace reaguje, je určujícím faktorem pro minimalizaci dopadu narušení bezpečnosti. Efektivní plán reakce na incidenty s využitím umělé inteligence musí být specifický a dobře propracovaný. Když je spuštěno upozornění, ať už na základě hlášení uživatele nebo automatické detekce jedním z vašich bezpečnostních nástrojů, potřebuje tým pro reakci jasný postup, kterým se bude řídit.

Prvním krokem je omezení úniku dat. Pokud uživatel neúmyslně zpřístupnil citlivá data do LLM, je okamžitou prioritou odebrat přístup a zabránit dalšímu vystavení se riziku. To může zahrnovat dočasné zablokování přístupu uživatele k nástroji nebo dokonce izolaci jeho počítače od sítě. Další fází je vyšetřování. Jaká data unikla? Kdo byl zodpovědný? Jak selhaly naše kontrolní mechanismy? Tato forenzní analýza je klíčová pro pochopení hlavní příčiny a prevenci opakování. Plán se musí konečně zabývat eradikací a obnovou, což zahrnuje informování dotčených stran v souladu se zákonem, přijetí kroků k odstranění dat dodavatelem umělé inteligence, pokud je to možné, a aktualizaci bezpečnostních zásad a kontrol na základě získaných poznatků. Zralý přístup k umělé inteligenci a řízení rizik znamená být stejně připraven reagovat na incident, jako mu předcházet.

Sledování a zlepšování vaší pozice v oblasti rizik AI

Řízení rizik v oblasti umělé inteligence není jednorázový projekt; jedná se o nepřetržitý cyklus hodnocení, zmírňování a zlepšování. Prostředí hrozeb je dynamické a neustále se objevují nové nástroje umělé inteligence a vektory útoků. Proto je sledování rizik vaší organizace v oblasti umělé inteligence v čase nezbytné pro zajištění účinnosti vaší obrany. To vyžaduje závazek k průběžnému monitorování a používání metrik ke kvantifikaci úrovně rizika a výkonnosti vašich kontrol.

Mezi klíčové ukazatele výkonnosti (KPI) může patřit počet zjištěných neschválených nástrojů umělé inteligence, objem zabráněných incidentů úniku dat a procento zaměstnanců, kteří absolvovali školení v oblasti bezpečnosti umělé inteligence. Pravidelné audity a penetrační testy, zaměřené konkrétně na systémy umělé inteligence, mohou také poskytnout neocenitelné poznatky o slabinách vaší obrany. Neustálým měřením a zdokonalováním svého přístupu vytváříte odolný bezpečnostní program, který se přizpůsobuje vyvíjejícím se výzvám světa řízeného umělou inteligencí. Tento proaktivní přístup zajišťuje, že vaše organizace může i nadále s jistotou a bezpečně využívat sílu umělé inteligence a transformovat potenciální zdroj katastrofického rizika na dobře řízenou strategickou výhodu.